Un rapporto sull'integrità delle informazioni delle Nazioni Unite nell'IA evidenzia il potenziale per i dirigenti del settore di colludere con i politici per diffondere disinformazione poco dopo che Sam Altman ha esercitato pressioni sul Congresso.

L'agenzia ha evidenziato come i governi potrebbero colludere con le aziende per diffondere disinformazione in linea con un'agenda politica o finanziaria.

I deepfake amplificano la disinformazione politicamente motivata

Secondo il rapporto, le parti coinvolte in queste interazioni sono spesso difficili da identificare. Politici, funzionari pubblici e stati-nazione a volte colludono con società di pubbliche relazioni per pubblicare informazioni false su cloni di piattaforme autentiche.

Secondo il rapporto:

"La disinformazione può essere una tattica deliberata di mezzi di comunicazione ideologicamente influenzati cooptati da interessi politici e aziendali".

Gli algoritmi spesso promuovono contenuti carichi di emozioni che catturano l'attenzione anche se la sostanza di un contenuto non è vera. I recenti progressi nell'intelligenza artificiale (AI) possono, suggerisce l'ONU, amplificare questo problema attraverso deepfake che riportano la disinformazione come fatti con una convinzione senza precedenti.

"L'era della filosofia "muoviti velocemente e rompi le cose" della Silicon Valley deve essere portata a termine".

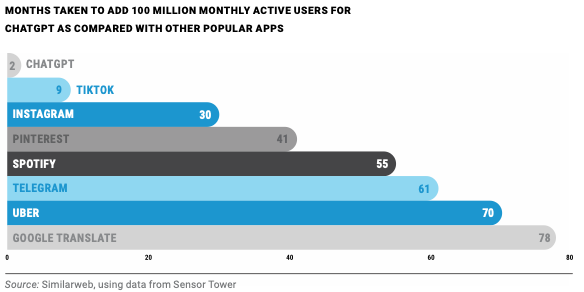

Il rapporto ha anche evidenziato come lo strumento ChatGPT di OpenAI sia diventato l'app consumer in più rapida crescita. Ha guadagnato 100 milioni di utenti in circa due mesi.

sulle piattaforme digitali

Il mese scorso, il CEO di OpenAI, Sam Altman, ha dichiarato ai legislatori statunitensi che l'intelligenza artificiale "può andare molto male".

Apparendo davanti a una sottocommissione del Senato, Altman ha invitato le autorità di regolamentazione a stabilire barriere per il progresso del settore. Tuttavia, i procedimenti ruotavano principalmente attorno alla minaccia dell'IA per l'umanità piuttosto che alla sua capacità di promuovere la disinformazione e aumentare la sorveglianza.

Secondo le Nazioni Unite, la disinformazione diffonde inconsapevolmente informazioni errate, mentre la disinformazione manomette deliberatamente i fatti.

Lobbying a Cautionary Tale di Sam Bankman-Fried

I partecipanti al settore dell'intelligenza artificiale che chiedono più regolamentazione assomigliano stranamente ai dirigenti tecnologici, le Nazioni Unite sottolineano che il coinvolgimento degli utenti in precedenza era prioritario rispetto ai diritti umani.

Sarah Myers West dell'AI Now Institute, che studia l'impatto sociale delle nuove tecnologie, ha recentemente affermato:

"Le aziende che stanno guidando la carica nel rapido sviluppo dei sistemi [AI] sono le stesse aziende tecnologiche che sono state chiamate davanti al Congresso per violazioni dell'antitrust, per violazioni della legge esistente o danni informativi nell'ultimo decennio".

Il famigerato lobbismo di Sam Bankman-Fried per i regolamenti sulle criptovalute, che non si è mai materializzato ed è culminato nel suo arresto per reati di frode, evidenzia come coinvolgere i partecipanti del settore nel processo legislativo possa ritorcersi contro.

La Securities and Exchange Commission degli Stati Uniti ha ripetutamente rifiutato di coinvolgere i lobbisti del settore sulpotenziale nuovo regolamento , sostenendo che le leggi esistenti sono sufficienti.

Ex dirigenti di banche fallite della Silicon Valley e Signature hanno fatto pressioni sul Congresso per allentare i requisiti patrimoniali del Dodd-Frank Act per le banche più piccole.

Entrambe le banche hanno subito una corsa a marzo dopo che i depositanti hanno testato quei requisiti più flessibili attraverso prelievi di massa.

Il lobbismo di Altman potrebbe limitare l'obiettiva regolamentazione dell'IA negli Stati Uniti

Altman ha recentemente suggerito una lista di controllo della conformità che, se soddisfatta, immunizzerebbe le aziende di intelligenza artificiale da ulteriori responsabilità. Ha anche richiesto audit di modelli linguistici di grandi dimensioni prima del rilascio.

Tuttavia, i gruppi per i diritti hanno precedentemente sostenuto che il lobbismo dei dirigenti tecnologici diluisce le leggi a vantaggio delle aziende.

Leggi qui sul passaggio di Meta all'intelligenza artificiale.

Mehtab Khan, uno studioso di ricerca presso lo Yale Information Society Project, ha lamentato l' unilateralità di questo approccio alla regolamentazione:

"Finiscono con regole che danno loro molto spazio per creare fondamentalmente meccanismi di autoregolamentazione che non ostacolino i loro interessi commerciali".

Ben Winters, consulente presso l'Electronic Privacy Information Center, non si aspetta che le leggi statunitensi affrontino presto la minaccia immediata dell'IA:

"Non posso in buona coscienza prevedere che il legislatore federale escogiterà qualcosa di buono nel prossimo futuro".

Nel frattempo, potenziali soluzioni normative statunitensi per l'IA potrebbero provenire dalla regola di rigetto della Federal Trade Commission degli Stati Uniti che obbliga le aziende a distruggere i set di dati raccolti illegalmente.

Le imprese possono anche essere tenute a rispettare gli standard antitrust per prevenire l'abuso delle loro posizioni di mercato.

Per l'ultima analisi di Bitcoin (BTC) di BeInCrypto, fai clic qui .

Il post Rapporto delle Nazioni Unite evidenzia i pericoli della disinformazione politica causati dall'ascesa dell'intelligenza artificiale è apparso per la prima volta su BeInCrypto .