Con l’evolversi dell’intelligenza artificiale (AI), il suo potenziale per rafforzare le misure di sicurezza informatica è diventato un punto focale per le aziende di tutto il mondo.

Con l’allarmante aumento della velocità, della portata e della sofisticazione degli attacchi informatici, le aziende stanno integrando sempre più le tecnologie di intelligenza artificiale per sconfiggere i criminali informatici.

Come Microsoft e OpenAI intendono migliorare la sicurezza informatica con l'intelligenza artificiale

Microsoft ha collaborato con innovatori dell'intelligenza artificiale come OpenAI per esplorare il ruolo dell'intelligenza artificiale nella sicurezza informatica . Nello specifico, le aziende stanno esaminando il modo in cui gli autori malintenzionati utilizzano in modo improprio l’intelligenza artificiale e come può essere utilizzata per la difesa. Inoltre, mirano a promuovere casi d’uso responsabili dell’IA , garantendo che i malintenzionati non li utilizzino per scopi dannosi.

L'iniziativa di Microsoft, in particolare con il suo Copilot for Security, esemplifica le misure proattive per potenziare la sicurezza informatica con strumenti basati sull'intelligenza artificiale. Questi sforzi sono in linea con mandati più ampi del settore, come l’ ordine esecutivo della Casa Bianca sull’intelligenza artificiale . L’ordinanza richiede rigorosi standard di sicurezza e protezione per i sistemi di intelligenza artificiale che incidono sulla sicurezza nazionale e sul benessere pubblico.

“Come parte di questo impegno, abbiamo adottato misure per interrompere risorse e account associati agli autori delle minacce, migliorare la protezione della tecnologia OpenAI LLM e degli utenti da attacchi o abusi e modellare i guardrail e i meccanismi di sicurezza attorno ai nostri modelli”, ha spiegato Microsoft.

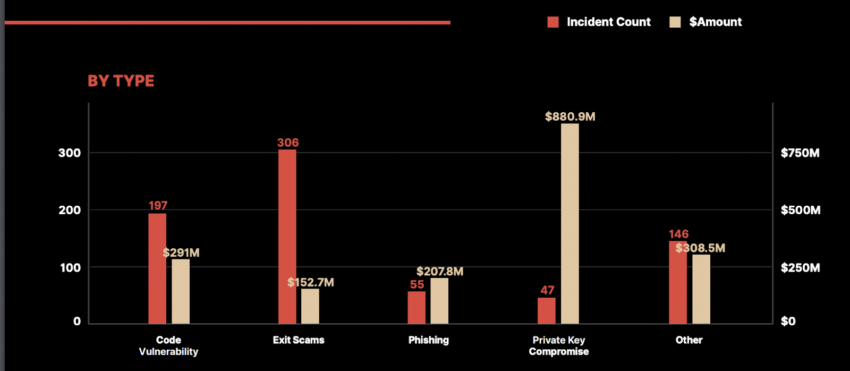

Nel 2023, il solo settore Web3 ha registrato una perdita sbalorditiva di 1,8 miliardi di dollari in 751 incidenti di sicurezza. Questi incidenti spaziavano da exploit di codice e attacchi di phishing a schemi più complessi come compromissioni di chiavi private e truffe di uscita, con queste ultime che rappresentano una parte significativa delle violazioni.

Per saperne di più: AI per gli audit dei contratti intelligenti: soluzione rapida o attività rischiosa?

Il costo finanziario più grave è derivato dalla compromissione delle chiavi private, che ha comportato una colossale perdita di 880,9 milioni di dollari per le aziende crittografiche. In effetti, questa vulnerabilità evidenzia la necessità fondamentale di solide misure di sicurezza nella salvaguardia delle informazioni sensibili.

In risposta a queste crescenti minacce, Microsoft ha progettato azioni politiche volte a interrompere l’uso dannoso dell’intelligenza artificiale da parte di attori identificati delle minacce, tra cui le minacce persistenti avanzate (APT) a livello nazionale e i sindacati dei criminali informatici. Questi principi comprendono l’identificazione e la neutralizzazione dell’uso dannoso dell’intelligenza artificiale, la collaborazione con altri fornitori di servizi di intelligenza artificiale per la condivisione delle informazioni sulle minacce e l’impegno alla trasparenza riguardo alle azioni intraprese contro gli autori delle minacce.

Per saperne di più: Sicurezza del progetto Crypto: una guida al rilevamento precoce delle minacce

La strategia di difesa congiunta di Microsoft e OpenAI offre uno sguardo al futuro della sicurezza informatica, in cui le capacità generative dell’intelligenza artificiale vengono sfruttate per contrastare attività dannose. Tracciando oltre 300 attori di minacce unici, inclusi attori di stati-nazione e gruppi di ransomware, Microsoft Threat Intelligence svolge infatti un ruolo cruciale nell’identificazione e nella mitigazione delle minacce facilitate dall’intelligenza artificiale.

Il post Come queste aziende utilizzeranno l'intelligenza artificiale per prevenire gli attacchi informatici è apparso per la prima volta su BeInCrypto .