I sofisticati progressi dell'intelligenza artificiale hanno dato origine a Large Language Models (LLM) come ChatGPT e Bard di Google. Queste entità possono generare contenuti così umani da sfidare la concezione dell'autenticità.

Mentre educatori e creatori di contenuti si radunano per evidenziare il potenziale uso improprio degli LLM, dall'imbroglio all'inganno, il software di rilevamento dell'IA afferma di avere l'antidoto. Ma quanto sono affidabili queste soluzioni software?

Software di rilevamento AI inaffidabile

A molti, gli strumenti di rilevamento dell'intelligenza artificiale offrono uno spiraglio di speranza contro l'erosione della verità . Promettono di identificare l'artificio, preservando la santità della creatività umana.

Tuttavia, gli informatici dell'Università del Maryland hanno messo alla prova questa affermazione nella loro ricerca di veridicità. I risultati? Un sobrio campanello d'allarme per il settore.

Soheil Feizi, assistente professore presso UMD, ha rivelato le vulnerabilità di questi rilevatori di intelligenza artificiale, affermando che sono inaffidabili in scenari pratici . La semplice parafrasi dei contenuti generati da LLM può spesso ingannare le tecniche di rilevamento utilizzate da Check For AI, Compilatio, Content at Scale, Crossplag, DetectGPT, Go Winston e GPT Zero, solo per citarne alcuni.

“La precisione anche del miglior rilevatore che abbiamo scende dal 100% alla casualità di un lancio di una moneta. Se parafrasiamo semplicemente qualcosa che è stato generato da un LLM, spesso possiamo superare in astuzia una serie di tecniche di rilevamento", ha affermato Feizi.

Questa realizzazione, sostiene Feizi, sottolinea la dicotomia inaffidabile degli errori di tipo I, in cui il testo umano viene erroneamente contrassegnato come generato dall'IA, e gli errori di tipo II, quando il contenuto dell'IA riesce a passare attraverso la rete senza essere rilevato.

Un caso degno di nota ha fatto notizia quando il software di rilevamento dell'IA ha erroneamente classificato la Costituzione degli Stati Uniti come generata dall'IA. Errori di tale entità non sono solo intoppi tecnici, ma potenzialmente danneggiano la reputazione , portando a gravi implicazioni socio-etiche.

Per saperne di più: Il rapporto delle Nazioni Unite evidenzia i pericoli della disinformazione politica causati dall'aumento dell'intelligenza artificiale

Feizi illumina ulteriormente la situazione, suggerendo che la distinzione tra contenuto umano e contenuto generato dall'intelligenza artificiale potrebbe presto essere difficile a causa dell'evoluzione degli LLM.

“Teoricamente, non si può mai affermare in modo affidabile che questa frase sia stata scritta da un essere umano o da una sorta di intelligenza artificiale perché la distribuzione tra i due tipi di contenuto è così vicina l'una all'altra. È particolarmente vero se si pensa a quanto sofisticati stanno diventando gli LLM e gli aggressori di LLM come i parafrasatori o lo spoofing", ha affermato Feizi.

Individuare elementi umani unici

Tuttavia, come con qualsiasi discorso scientifico, esiste una contro-narrativa. UMD Assistant Professor of Computer Science Furong Huang ha una prospettiva più solare.

Postula che con ampi dati che indicano ciò che costituisce il contenuto umano, la differenziazione tra i due potrebbe essere ancora raggiungibile. Man mano che gli LLM affinano la loro imitazione nutrendosi di vasti archivi testuali, Huang ritiene che gli strumenti di rilevamento possano evolversi se viene loro concesso l'accesso a campioni di apprendimento più estesi .

La squadra di Huang si concentra anche su un elemento umano unico che potrebbe essere la grazia salvifica. La diversità innata all'interno del comportamento umano, che comprende stranezze grammaticali uniche e scelte di parole, potrebbe essere la chiave.

“Sarà come una corsa agli armamenti costante tra AI generativa e rivelatori. Ma speriamo che questa relazione dinamica migliori effettivamente il modo in cui ci avviciniamo alla creazione sia degli LLM generativi che dei loro rilevatori in primo luogo", ha affermato Huang.

Il dibattito sull'efficacia del rilevamento dell'IA è solo un aspetto del più ampio dibattito sull'IA. Feizi e Huang concordano sul fatto che vietare apertamente strumenti come ChatGPT non è la soluzione. Questi LLM hanno un immenso potenziale per settori come l'istruzione.

Leggi di più: Un nuovo studio rivela che ChatGPT sta diventando più stupido

Invece di lottare per un sistema improbabile e infallibile al 100%, l'accento dovrebbe essere posto sul rafforzamento dei sistemi esistenti contro le vulnerabilità note.

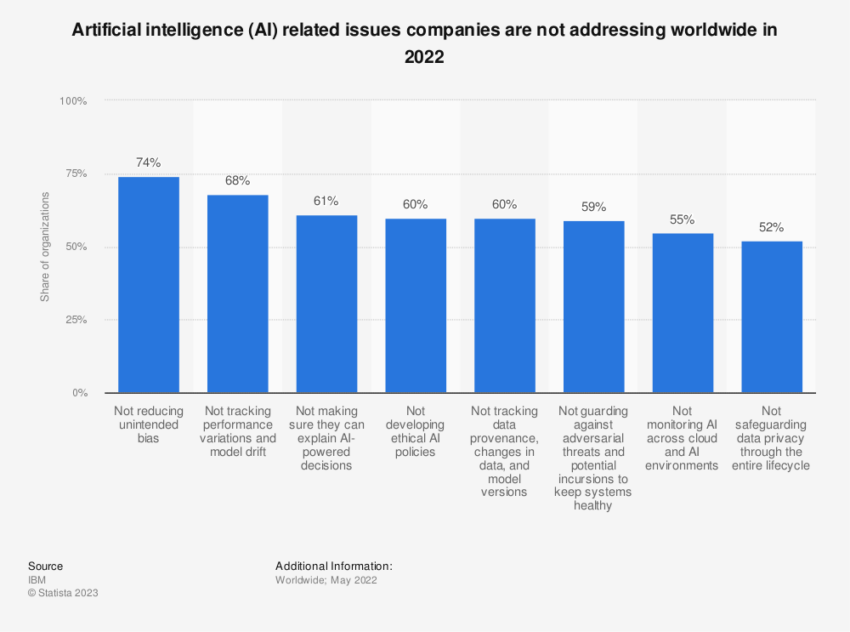

La crescente necessità di una regolamentazione dell'IA

Le salvaguardie future potrebbero non basarsi esclusivamente sull'analisi testuale. Feizi accenna all'integrazione di strumenti di verifica secondari, come l'autenticazione del numero di telefono collegata all'invio di contenuti o l'analisi del modello comportamentale.

Questi livelli aggiuntivi potrebbero migliorare le difese contro il falso rilevamento dell'IA e i pregiudizi intrinseci.

Mentre l'intelligenza artificiale potrebbe essere coperta da incertezze, Feizi e Huang sono enfatici sulla necessità di un dialogo aperto sull'utilizzo etico degli LLM. Esiste un consenso collettivo sul fatto che questi strumenti, se sfruttati in modo responsabile, potrebbero apportare benefici significativi alla società, in particolare nell'istruzione e nella lotta alla disinformazione.

Leggi di più: Questi tre miliardari sono rialzisti sull'intelligenza artificiale, ribassisti su Crypto

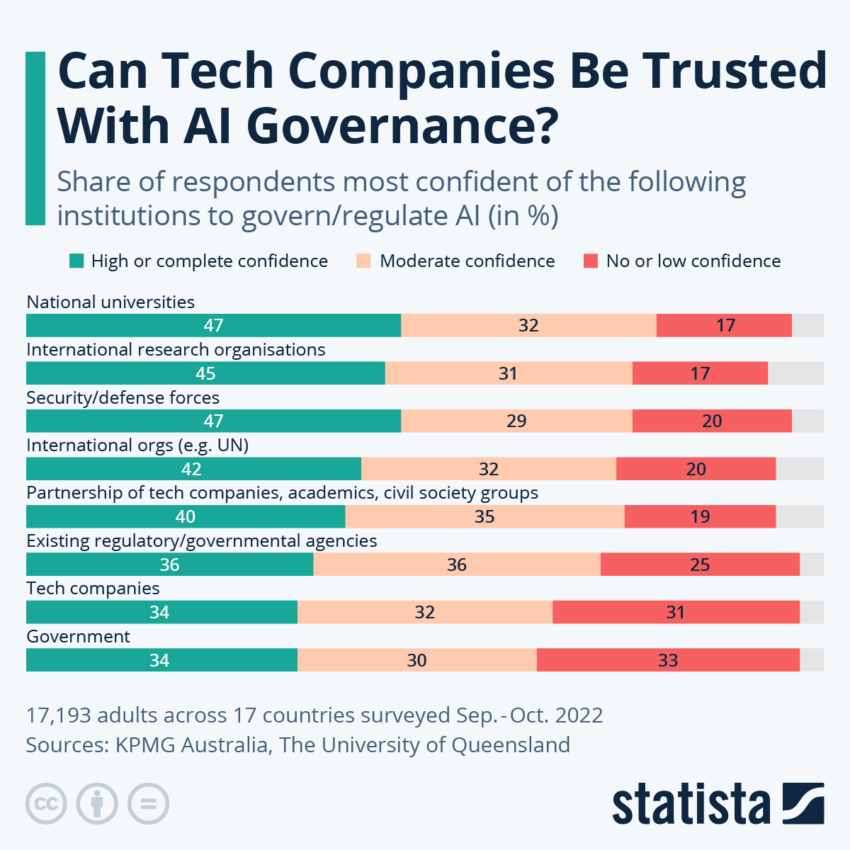

Tuttavia, il viaggio da percorrere non è privo di sfide. Huang accentua l'importanza di stabilire regole di base fondamentali attraverso discussioni con i responsabili politici.

Un approccio dall'alto verso il basso, sostiene Huang, è fondamentale per garantire un quadro coerente che governi gli LLM mentre la comunità di ricerca persegue incessantemente rilevatori e filigrane migliori per frenare l'uso improprio dell'IA.

Il post Gli strumenti di rilevamento AI non riescono a individuare gli imbroglioni è apparso per la prima volta su BeInCrypto .

: possiamo quasi sempre rilevare con sufficienti osservazioni!

: possiamo quasi sempre rilevare con sufficienti osservazioni!